BigNeuron : révolutionner la reconstruction neuronale grâce à l’intelligence artificielle

résumé: Les chercheurs ont publié un article détaillant leur projet BigNeuron. Cette initiative vise à normaliser les méthodes de reconstruction automatisée précise et rapide des neurones, à l’aide d’algorithmes d’apprentissage en profondeur.

Le projet offrira une large gamme d’images de reconstruction nerveuse accessibles au public et des outils puissants pour une analyse indépendante. Cela peut aider les chercheurs à comprendre le fonctionnement du cerveau et les changements au fil du temps.

Faits marquants:

- BigNeuron est une initiative internationale impliquant des informaticiens et des neuroscientifiques de plusieurs institutions, et vise à créer un cadre standard pour la reconstruction automatique des neurones.

- Le projet fournira un vaste ensemble de données d’images de reconstructions neuronales accessibles au public, ainsi que de puissants outils d’analyse.

- L’équipe a développé un algorithme automatisé utilisant l’apprentissage en profondeur pour distinguer la forme de chaque neurone dans une image, surmontant les défis de la diversité des espèces, de l’emplacement du cerveau, des stades de développement et de la qualité variable des ensembles d’images.

source: Texas A&M

Le Dr Xuyang Jie, professeur au Département d’informatique et d’ingénierie de la Texas A&M University, fait partie d’une communauté de recherche collaborative qui a récemment publié un article intitulé « BigNeuron : une ressource pour mesurer et prédire la performance des algorithmes de suivi automatisé des Neurones in Optical Microscopy Datasets » publié dans le numéro du magazine April les chemins de la nature.

Lancée en 2015 et dirigée par l’Allen Institute for Brain Science, BigNeuron est une initiative internationale qui rassemble des informaticiens et des neuroscientifiques de dizaines d’institutions.

Son objectif est de développer un cadre standard pour aider les chercheurs à identifier les meilleures méthodes et algorithmes pour reconstruire rapidement et avec précision les neurones. Ensuite, « bench test » les algorithmes sur de grands ensembles de données d’images à l’aide de superordinateurs.

Le projet aboutira à un vaste ensemble d’images de données de reconstruction neuronale accessibles au public, ainsi qu’à de puissants outils et algorithmes que les chercheurs pourront utiliser dans leurs travaux d’analyse.

Rien que dans le cerveau humain, il y a des centaines de milliards de neurones, et ils sont interconnectés par des milliers de fines « branches », formant une structure tridimensionnelle.

Pour comprendre comment le cerveau fonctionne et change au fil du temps, les scientifiques doivent pouvoir reconstruire numériquement ces structures neuronales pour voir à quoi ressemble chaque neurone de l’image.

En utilisant des microscopes à haute résolution pour capturer des images 3D de neurones individuels, les scientifiques ont développé des moyens entièrement automatisés pour reconstruire les neurones depuis près de 40 ans.

Leur reconstitution est restée un défi en raison de la diversité des espèces, de la localisation du cerveau, des stades de développement et de la qualité des collections de micrographies.

Ces facteurs rendent difficile la généralisation efficace des algorithmes actuels lorsqu’ils sont appliqués à des tailles d’images obtenues par différents laboratoires.

Pour atténuer ce problème, l’équipe a développé un algorithme automatisé utilisant l’apprentissage en profondeur pour apprendre la forme de chaque neurone dans une image donnée.

À propos de cette recherche sur l’intelligence artificielle et les nouvelles neurosciences

auteur: Leslie Hinton

source: Texas A&M

communication: Leslie Henton – Texas A&M

image: Image créditée à Neuroscience News

Recherche originale : Accès fermé.

« BigNeuron : une ressource pour mesurer et prédire les performances des algorithmes de suivi automatisé des neurones dans les ensembles de données de microscopie optique.Par Shuiwang Ji et al. les chemins de la nature

un résumé

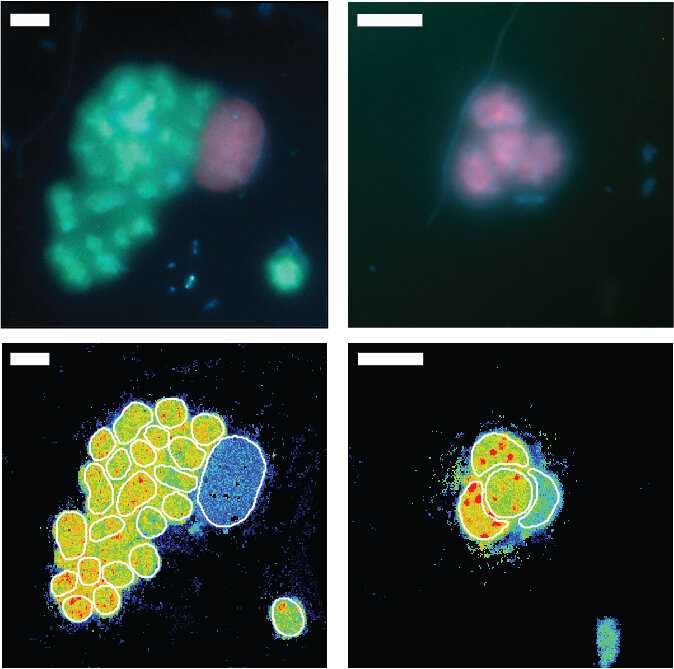

BigNeuron est une plateforme de test communautaire ouverte qui vise à établir des normes ouvertes pour un traçage précis et rapide des neurones. Nous avons collecté une variété de tailles d’images dans plusieurs types qui représentent des données obtenues dans plusieurs laboratoires de neurosciences intéressés par le suivi des neurones.

Ici, nous rapportons l’annotation manuelle de référence d’un sous-ensemble d’ensembles de données d’imagerie disponibles et la qualité de suivi quantitatif de 35 algorithmes de suivi automatique. L’objectif de créer un ensemble aussi diversifié de données organisées manuellement est de faire progresser le développement d’algorithmes de suivi et de permettre une analyse comparative généralisable.

Outre les fonctionnalités de qualité d’image, nous avons agrégé les données dans une application Web interactive qui permet aux utilisateurs et aux développeurs d’effectuer une analyse en composantes principales, RIncorporation distribuée de voisins aléatoires, corrélation, agrégation, visualisation des données d’imagerie et de suivi, et analyse comparative des algorithmes de suivi automatique sur des sous-ensembles de données définis par l’utilisateur. Les mesures de qualité d’image expliquent la majeure partie de la variance des données, suivies des caractéristiques neuromorphiques liées à la taille des neurones.

Nous avons noté que divers algorithmes peuvent fournir des informations complémentaires pour des résultats précis et avons développé une méthode pour combiner de manière itérative les méthodes et générer des reconstructions consensuelles.

Les arbres de consensus obtenus fournissent des estimations de vérité terrain de la structure neuronale qui surpassent généralement les algorithmes individuels dans des ensembles de données bruyants. Cependant, des algorithmes spécifiques peuvent surpasser la stratégie de l’arbre consensus dans des conditions d’imagerie spécifiques.

Enfin, pour aider les utilisateurs à prédire les résultats de suivi automatique les plus précis sans annotations de comparaison manuelles, nous avons utilisé la régression de la machine vectorielle pour prédire la qualité de la reconstruction en fonction de la taille de l’image et d’un ensemble d’opérations de suivi automatique.