« L’alpaga à Stanford est un animal très différent » par Bablulawrence | Mars 2023

Alpaca, développé par des chercheurs de l’Université de Stanford, est une évolution remarquable de l’IA générative.

De nos jours, il n’est pas rare que quelque chose de cool sorte chaque semaine du monde de l’IA. Cependant, la semaine dernière, il y a eu quelque chose comme une explosion, tellement d’annonces et de piratages qu’il était difficile de garder une trace de tout cela. Si vous ne l’avez pas encore vu, voici quelques-uns des plus importants :

- depuis longtemps GPT-4 Publié par OpenAI. En plus des améliorations par rapport à GPT-3.5 dans des domaines tels que le raisonnement et la brièveté, il a été révélé qu’il possède des capacités multimédias – bien qu’il n’ait pas encore été mis à la disposition du public. Microsoft a également confirmé qu’une première version de GPT-4, optimisée pour la recherche, est déjà utilisée par Bing.

- Google a annoncé l’intégration de la synthèse L’intelligence artificielle dans Google Workspaces.

- Google a également révélé API PaLM et suite Maker, permettant aux développeurs d’utiliser des applications de création avec des capacités génératives d’intelligence artificielle. PaLM est un modèle multimédia capable de générer des images, des vidéos et de l’audio à partir d’invites, ainsi que de générer du texte de style GPT que nous connaissons tous.

- Microsoft a également révélé son intention d’intégrer des capacités d’IA générative dans Famille de produits Microsoft 365. Bientôt, les utilisateurs pourront demander à MS Office d’effectuer des tâches telles que la création de présentations PowerPoint, la création automatique de réponses par e-mail ou l’analyse de données, etc.

- pris en charge par Google anthropique Lancé Claudeun assistant chatbot alimenté par l’IA qui, selon eux, produit un résultat plus fiable que ses concurrents.

- Midjourney, une application de conversion texte-image populaire, a publié la version 5. Si vous êtes un fan de l’art de l’IA (oui, c’est une chose), vous l’attendiez probablement avec impatience. Sinon, regardez ce que les gens en pensent ici – il est magnifique.

Mais le développement qui a le plus retenu mon attention est celui de Stanford modèle d’alpagaqui a été publié un jour avant GPT-4 et n’a probablement pas reçu l’attention qu’il méritait à cause de cela et de toutes les autres annonces.

Alpaca est essentiellement une instruction qui suit un modèle de langage qui peut s’exécuter sur un ordinateur portable suffisamment puissant et produire une sortie d’environ GPT 3.5 !

Imaginez pouvoir exécuter ChatGPT sur votre ordinateur portable (vous en avez besoin d’un haut de gamme, mais quand même), qui peut répondre aux questions sur vos données personnelles. C’est vraiment exceptionnel !

Pour vraiment comprendre ce que sont les alpagas et comment ils ont été créés, nous devons d’abord jeter un œil à leur base – Modèle Meta LLaMA.

Commencer avec une petite mais puissante entreprise

Meta a lancé LLaMa Models le mois dernier dans le but d’aider les chercheurs qui n’ont pas accès aux grandes quantités d’infrastructures nécessaires pour former les grands modèles de langage (LLM) de nos jours. Il s’agit d’un modèle de base disponible en quatre tailles (paramètres 7B, 13B, 33B et 65B), qui peuvent être personnalisés à différentes fins, telles que la prédiction de structures protéiques, la résolution de problèmes mathématiques ou la création de texte créatif. Selon Meta, bon nombre de ces modèles, en particulier le plus grand paramètre – 65B, sont supérieurs au GPT-3.5, qui est d’un ordre de grandeur supérieur aux paramètres 175B.

Modèles fondamentaux Il s’agit d’une classe de modèles d’apprentissage automatique qui servent de base à la création d’une grande variété d’applications dans divers domaines. Ces modèles, souvent à grande échelle et alimentés par des techniques d’apprentissage en profondeur, sont formés sur de grandes quantités de données diverses pour développer une large compréhension du langage, du contexte et des connaissances.

À certains égards, il ressemble àSoupe primordiale« , qui, dans le contexte de l’origine de la vie, fait référence au mélange de composés organiques qui a donné naissance aux premiers organismes sur Terre par des réactions chimiques et des processus naturels. Semblable à une soupe primordiale, ils fournissent une base polyvalente à partir de laquelle divers Des applications et des solutions d’IA peuvent émerger.Ces modèles sont formés sur d’énormes quantités de données diverses, ce qui leur permet d’acquérir un large éventail de connaissances et de compréhension du langage.Bien qu’ils ne soient pas très utiles directement, ils peuvent être adaptés ou affinés pour tâches ou domaines spécifiques, ce qui a conduit à l’émergence de nombreuses applications de l’intelligence artificielle.

Le modèle de base le plus important de tous – GPT-3 et versions ultérieures – n’est pas open source. Ils sont également de grande taille et nécessitent une infrastructure informatique importante pour fonctionner. C’est là que LLaMa brille; En créant des modèles de base de différentes tailles que d’autres peuvent ajuster pour effectuer différentes tâches, Meta a permis aux chercheurs de progresser plus rapidement dans leurs domaines.

Utiliser GPT 3.5 comme entraîneur

Cependant, ce n’est pas la petite taille elle-même qui est la chose intéressante à propos des alpagas ; Au lieu de cela, c’est la façon dont ils sont formés et la rapidité avec laquelle ils le font.

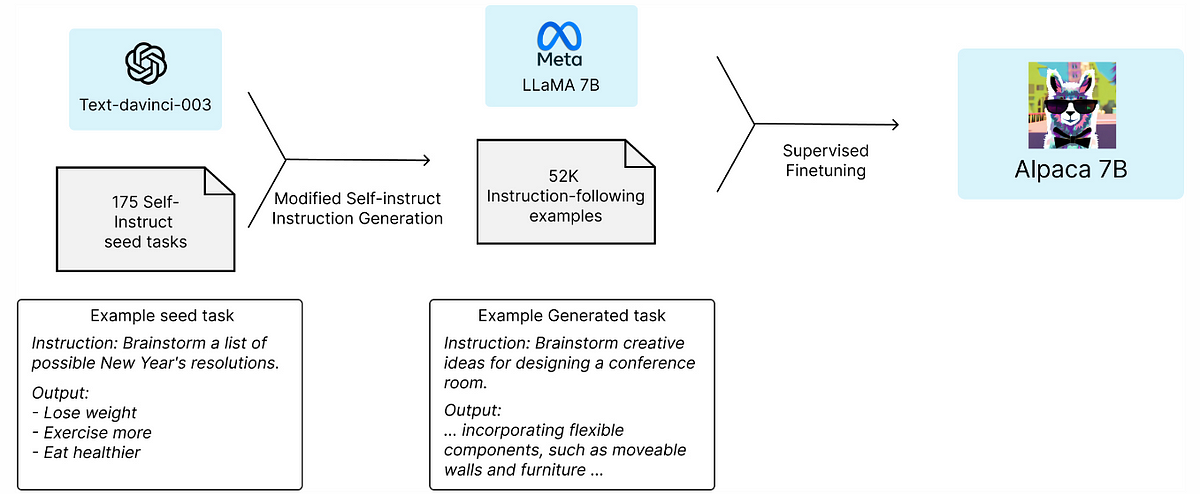

Le défi principal est de rendre le modèle constitutif LLaMa capable de suivre les instructions humaines. Pour cela, les chercheurs ont profité de Auto-assistance Un cadre qui aide les modèles de langage à améliorer leur capacité à suivre les instructions en langage naturel. Tout d’abord, ils ont commencé avec 175 jeux d’instructions manuscrites, qui ont ensuite été portés dans GPT-3.5 (text-davinci-003) pour créer un ensemble d’échantillons plus grand de 52k. Cet ensemble a ensuite été utilisé pour former le modèle constitutif, qui a ensuite été modifié par apprentissage supervisé. En comparant les sorties, les chercheurs ont découvert, de manière surprenante, que ces deux modèles avaient des performances très similaires.

Cette approche réduit considérablement l’effort manuel requis pour créer un formulaire utile pour suivre les instructions d’un formulaire de base avec un formulaire Distillation des connaissances.

Considérez le LLaMA comme un chef novice qui possède une connaissance approfondie des ingrédients et des techniques de cuisine de base, mais qui a besoin de conseils pour créer des plats spécialisés. L’exemple d’instruction suivant est comme un chef apprenant à suivre des recettes spécifiques, perfectionnant ses compétences pour devenir un cuisinier plus accompli.

Dans cette analogie, le LLaMA représente le chef novice avec une base solide, tandis que le GPT-3.5 agit comme un maître cuisinier qui a perfectionné son art au fil du temps et peut créer des plats exquis avec précision. En tirant parti de l’expérience de GPT-3.5, les développeurs d’Alpaca ont pu guider un modèle LLaMA novice et l’aider à apprendre des techniques et des méthodes plus avancées.

Au fur et à mesure qu’un chef novice (LLaMA) reçoit les conseils d’un chef cuisinier (GPT-3.5), il devient progressivement plus qualifié, perfectionne ses capacités et devient apte à préparer des plats de haute qualité. Ceci est similaire à Alpaca, qui, après avoir été formé avec la connaissance de GPT-3.5, peut effectuer des tâches avec un niveau d’efficacité similaire à celui du modèle plus grand mais à une fraction du coût et des besoins en ressources.

Plus petit, moins cher et presque aussi bon que GPT-3.5

construction text-davinci-003Fondamentalement, le modèle d’aide-suivi construit à partir des modèles de base GPT a nécessité plus d’efforts, d’infrastructure et de nombreux mois de formation. Les alpagas, en revanche, ont été entraînés en quelques jours par une poignée de personnes à un coût remarquablement bas et ont obtenu à peu près les mêmes performances.

Il reste à voir quel type de performances un modèle construit sur la base des plus grands modèles LLaMa peut atteindre en utilisant une approche similaire.

A noter que les alpagas sont dédiés Uniquement pour la recherche académique et toute utilisation commerciale est interdite. Principalement parce que LLaMA, il a une licence non commerciale, et les conditions d’utilisation de text-davinci-003 interdisent le développement de modèles qui concurrencent OpenAI. Mais aussi parce que les mesures de sécurité adéquates n’ont pas encore été mises en place.

Si vous regardez attentivement, vous pouvez supposer qu’il y a une sorte d' »accélération du transfert de connaissances » en cours. Avant l’avènement de modèles de suivi d’instructions de haute qualité tels que GPT-3.5, il n’était pas possible de générer de grandes quantités d’ensembles d’instructions d’entraînement en peu de temps à partir de très petits ensembles de semences. De plus, sans doute, l’ensemble d’entraînement 52K peut ne pas être suffisant pour affiner un modèle afin d’obtenir des instructions de tâche à suivre de haute qualité jusqu’à ce qu’il devienne aussi bon qu’un modèle comme LLaMa.

Une autre façon de penser à cela est une sorte d ‘ »adaptation d’impédance » comme les circuits électriques, où GPT-3.5 aide les chercheurs à faire correspondre les impédances du modèle constitutif pour obtenir le résultat souhaité. À mesure que les modèles d’IA deviennent plus avancés, ils peuvent faciliter un transfert plus rapide des connaissances des humains aux machines, leur permettant de résoudre des problèmes de plus en plus complexes. Ce processus d’adaptation d’impédance permet aux chercheurs d’affiner les modèles de base, d’améliorer leurs performances et de s’assurer qu’ils sont compatibles avec des tâches ou des domaines spécifiques.

Par conséquent, on pourrait dire qu’à mesure que les modèles s’améliorent, il devient exponentiellement plus facile de créer de nouveaux modèles meilleurs, ou en d’autres termes, plus facile de transférer « la connaissance et l’intelligence » des humains aux machines et de les utiliser pour résoudre des problèmes complexes.

Cependant, le développement et l’adoption de modèles tels que l’alpaga soulèvent des opportunités et des risques importants. D’une part, ils soulèvent des questions importantes sur l’avenir de l’IA, notamment en ce qui concerne le partage des connaissances et la concurrence. À mesure que les petites entreprises accèdent à de nouveaux modèles grâce à l’utilisation d’API et de technologies de formation plus efficaces, les grandes entreprises peuvent avoir de plus en plus de mal à conserver un avantage concurrentiel.

Bien sûr, cela soulève également des questions sur le taux de progrès exponentiel des systèmes d’IA et l’impact sur la société dans son ensemble, qui est un sujet très complexe au-delà de la portée de ce billet de blog.

Reste à savoir comment tout cela finira.